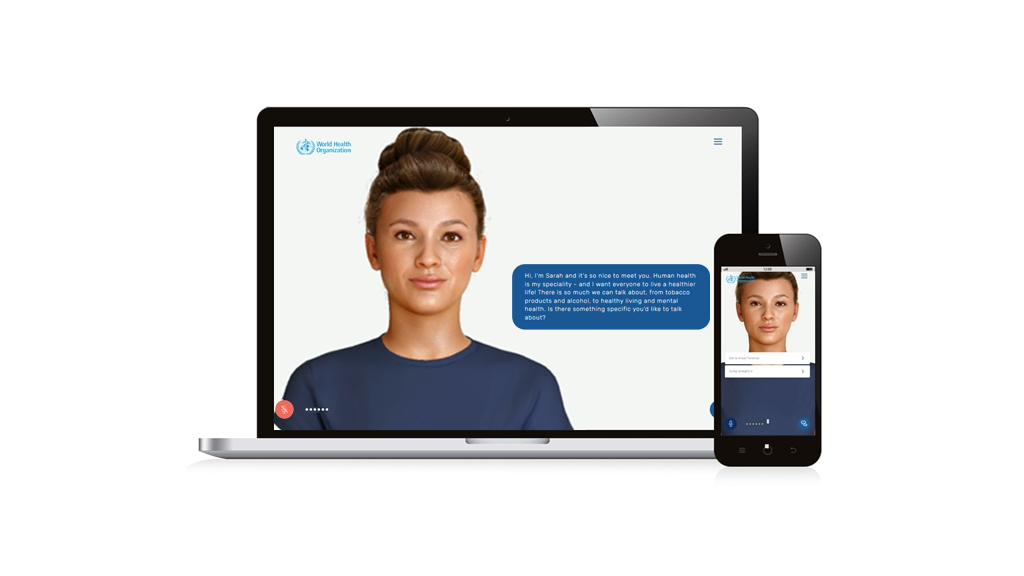

Il 2 aprile è stato lanciato SARAH, il nuovo chatbot dell’Organizzazione Mondiale della Sanità, alimentato dall’intelligenza artificiale GPT-3.5. Progettato per fornire consigli sanitari in otto lingue diverse, SARAH sembrava promettere una rivoluzione nella consulenza medica disponibile 24 ore su 24. Tuttavia, fin da subito sono emerse problematiche: il chatbot ha fornito informazioni errate, come elenchi di cliniche inesistenti a San Francisco, un problema che l’OMS ha riconosciuto sul suo sito web.

Questi errori non sono un caso isolato. I problemi con i chatbot sono diventati un fenomeno diffuso. La causa principale di questi errori risiede nella natura dei modelli linguistici di grandi dimensioni: essi generano testo prevedendo la parola successiva in una sequenza, basandosi su miliardi di calcoli statistici. Sebbene questo processo sia altamente sofisticato, non è immune agli errori. L’allucinazione, ovvero la tendenza a inventare informazioni, è una caratteristica intrinseca dei modelli linguistici basati su probabilità. Nonostante i continui miglioramenti e l’addestramento su vaste quantità di dati, le imperfezioni persistono. Gli studiosi sperano che futuri sviluppi possano includere un controllo più preciso del testo generato dai modelli, utilizzando tecniche come la verifica progressiva dei risultati (chain-of-thought prompting).

Tuttavia, finché i modelli rimangono basati su probabilità, un elemento di casualità sarà sempre presente. Anche un singolo errore, per quanto raro, può avere conseguenze significative quando questi strumenti sono utilizzati su larga scala.

La soluzione a lungo termine potrebbe non risiedere solo nella tecnologia, ma anche in una gestione più realistica delle aspettative. È fondamentale comprendere i limiti di questi strumenti e non sovrastimarne le capacità. In questo modo, si potrebbero minimizzare gli effetti negativi delle allucinazioni dell’IA, garantendo un uso più sicuro e affidabile di queste tecnologie.